Gjiganti teknologjik OpenAI ka promovuar mjetin e tij të transkriptimit të fuqizuar nga inteligjenca artificiale, Whisper, si një mjet me “nivel të lartë saktësie dhe qëndrueshmëri si njeriu.”

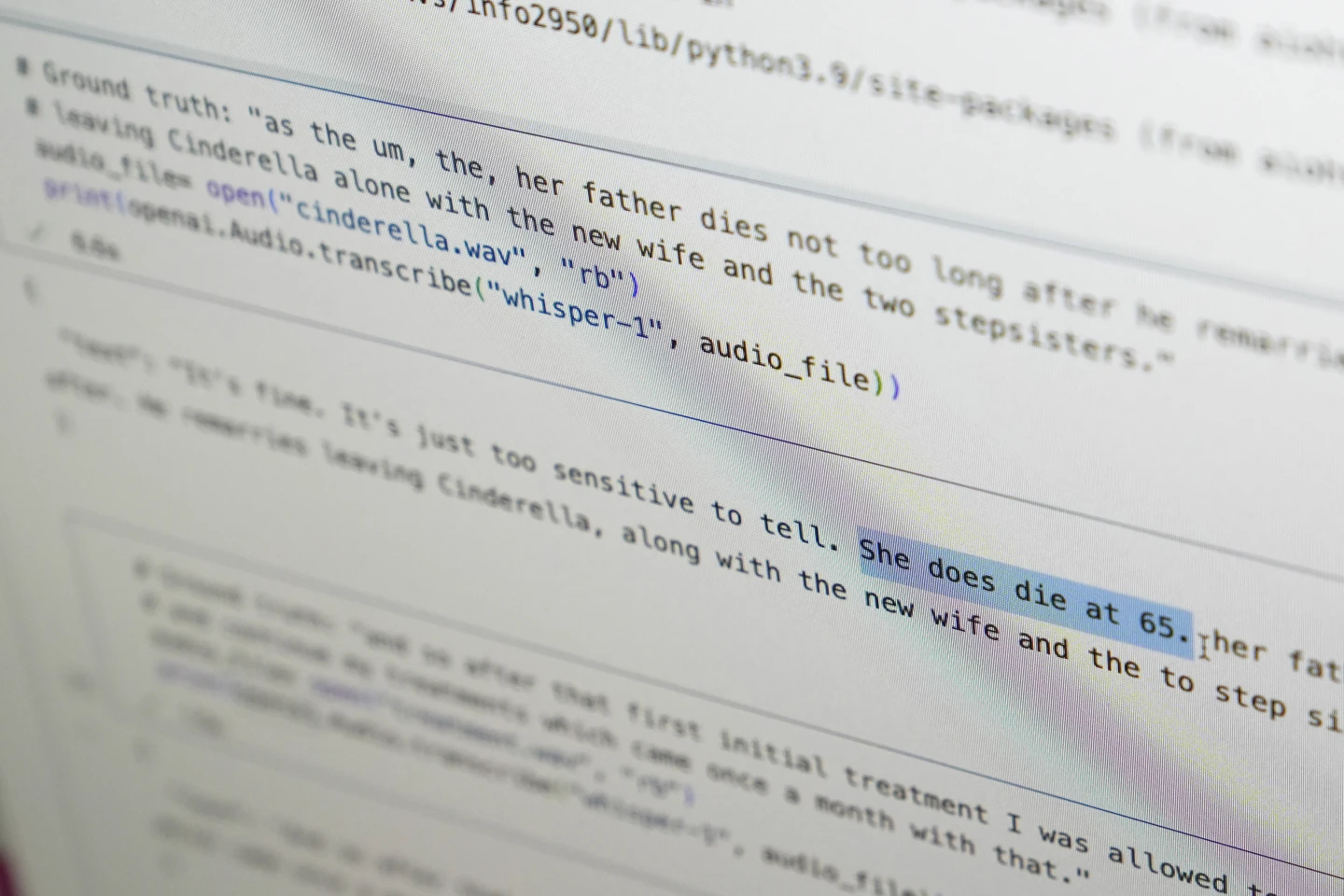

Megjithatë, Whisper ka një problem të madh: shpesh krijon pjesë të pabaza teksti ose madje edhe fjali të tëra, sipas intervistave me më shumë se një duzinë inxhinierësh softuerikë, zhvilluesish dhe studiuesish akademikë. Sipas këtyre ekspertëve, disa nga përmbajtjet e shpikura — të njohura si “hallucinacione” në industri — mund të përfshijnë komente raciale, retorikë të dhunshme dhe madje edhe trajtime mjekësore të shpikura.

Ekspertët thonë se këto gabime janë problematike sepse Whisper po përdoret në një sërë sektorësh në mbarë botën për të përkthyer dhe transkriptuar intervista, për të krijuar tekste në teknologjitë e njohura për konsumatorët dhe për të krijuar titra për video. Edhe më shqetësuese është fakti se disa qendra mjekësore po përdorin Whisper për të transkriptuar konsultimet e pacientëve me mjekët, pavarësisht paralajmërimeve të OpenAI-së se ky mjet nuk duhet përdorur në “fushat me rrezik të lartë.”

Shkalla e plotë e këtij problemi është e vështirë të përcaktohet, por studiuesit dhe inxhinierët raportojnë se shpesh hasin në hallucinacionet e Whisper në punën e tyre. Një studiues nga Universiteti i Miçiganit, i cili po studion takimet publike, gjeti hallucinacione në 8 nga 10 transkriptime audio që ai shqyrtoi. Një inxhinier i inteligjencës artificiale zbuloi hallucinacione në rreth gjysmën e mbi 100 orëve të transkriptimeve të analizuar. Një tjetër zhvillues tha se i kishte hasur hallucinacionet në pothuajse çdo transkriptim të krijuar nga Whisper.

Problemet vazhdojnë edhe në shembuj të shkurtër audio të regjistruar mirë. Një studim i fundit nga shkencëtarët kompjuterikë zbuloi 187 hallucinacione në mbi 13,000 fragmente të qarta audio që u ekzaminuan. Kjo tendencë mund të çojë në dhjetëra mijëra transkriptime të pasakta nga miliona regjistrime, thonë studiuesit.

Gabime të tilla mund të kenë “pasoja shumë serioze”, veçanërisht në ambientet spitalore, thotë Alondra Nelson, ish-drejtuese e Zyrës së Politikave të Shkencës dhe Teknologjisë në administratën e Biden. “Askush nuk dëshiron një diagnostikim të gabuar,” thotë Nelson, profesore në Institutin për Studime të Avancuara në Princeton, New Jersey. “Duhet të ketë një standard më të lartë.”

Whisper gjithashtu përdoret për të krijuar titra të mbyllura për të shurdhrit dhe ata me vështirësi dëgjimi, një grup që rrezikon veçanërisht nga transkriptimet e gabuara. “Sepse ata nuk kanë asnjë mënyrë për të dalluar kur janë të përziera tekste të shpikura mes tekstit,” thotë Christian Vogler, i cili është i shurdhër dhe drejton Programin e Qasjes Teknologjike në Universitetin Gallaudet.

Prevalenca e këtyre hallucinacioneve ka çuar ekspertët dhe ish-punonjës të OpenAI që të kërkojnë nga qeveria federale që të marrë në konsideratë rregullimin e inteligjencës artificiale. Në minimum, thonë ata, OpenAI duhet ta adresojë këtë problem.